Trascrizione e riproduzione dell’intervento di Stefania Milan alla giornata Contesto Urbano dello scorso 25 gennaio.

Vengo dalla campagna veneta anche se mi sono ritrovata a vivere in parecchie città gentrificate: Toronto, Amsterdam… Conosco Milano molto poco, per cui i miei esempi non si riferiranno a Milano ma, di fatto, i fenomeni di cui sto per parlarvi sono sempre meno geografici, cioè sono molto radicati nel territorio, hanno grandissime influenze nel territorio, a livello di esclusione sociale, di lotta alla diversità, eccetera, ma si stanno riproponendo in modo pressoché uguali, sia centro che periferia, sia nord che sud, est ed ovest; chiaramente con delle discriminanti: in un Paese dove c’è una legge, insomma uno stato di Diritto, forte, esistono diritti come quello alla Privacy che, in teoria, sono al fianco dei cittadini; comunque qui siamo in una condizione privilegiata ma i problemi sono uguali più o meno per tutti.

Lavoro in un collettivo di ricerca, nonostante siamo in una situazione molto gerarchica, come in università, basata sulla proprietà dell’idea, stiamo cercando di ricreare, un po’ come avete fatto voi qua con OffTopic, uno spazio di autonomia collettiva, quindi stiamo cercando attivamente di contravvenire a tutte le regole possibili e immaginabili nelle varie discipline e al modo in cui gestiamo i soldi e ci comportiamo comunque abbiamo la fortuna di avere anche dei fondi europei che ci permettono di fare queste cose comunque le cose che vi racconterò sono state il frutto di conversazioni con persone che vedete là e anche con una serie di altre persone.

Allora, vi parlerò di, tra le varie cose, di intelligenza artificiale, di tre fenomeni collegati che sono la digitalizzazione, la dataficazione e l’automazione, quindi tre fenomeni che sono molto collegati, che hanno le radici negli anni ’50, ’60, che diventano di massa negli anni ’90, che si moltiplicano in termini di complessità molto più recentemente e che adesso sono risultati in questa enfasi dell’intelligenza artificiale. Cercherò di parlarvi di tre problemi, tre sfide, tra i molteplici che potremmo avere ma è sabato pomeriggio quindi cerchiamo di essere ottimisti, e quelle che potrebbero essere tre vie di fuga, attiva e collettiva, quindi tre modalità di risposta a questi fenomeni con degli esempi concreti che si basano su software ma non solo.

La prima “sfida” è quella del riconoscimento facciale. Siamo in un contesto di cambiamenti epocali, cioè non so se quelle due immagini vi dicono qualcosa, si riferiscono, per farla breve, a due rappresentazioni del mondo, quella pre-copernicana, dove il posizionamento della Terra rispetto al Sistema Solare era diverso rispetto a quello che conosciamo noi oggi; queste due visioni del mondo sono state predominanti e la prima per molto tempo, hanno a che fare anche con la visione del potere: della religione, eccetera eccetera.

Il cambiamento epocale che è stato determinato dalla Rivoluzione Copernicana è, a mio avviso, quello che stiamo vivendo adesso, cioè come abbiamo cambiato il modo di vedere il mondo, all’epoca, con l’avvento dell’intelligenza artificiale il cambiamento è di una portata simile, poiché quelli della visione sono cambiamenti relativamente lenti non ce ne rendiamo conto, ma il paradigma cambia tanto quanto.

Questo ha a che fare molto con il ruolo dell’individuo nella società e il ruolo dei diritti individuali. Questo sistema ha a che fare con il Neo-liberalismo e il Capitalismo, alcuni l’hanno chiamato ovviamente surveillance capitalism ovvero Capitalismo della Sorveglianza, che si basa sulla raccolta continua ed estrema di dati personali, con poi la costruzione di senso sulla base di questi dati personali, altri l’hanno chiamato Colonialismo dei dati. Io credo che alla fine di tutte le etichette e le metafore che possiamo recuperare, il buon vecchio cattivo Capitalismo è il sistema dentro il quale ci troviamo che però si arricchisce di una dimensione nuova ch’è appunto quella dei dati.

Il primo problema è appunto quello della tecnica del riconoscimento facciale: si tratta di raccogliere dei dati e delle foto di matrici uniche e di collegarle a dei database esistenti o con database che vengono creati e usare queste informazioni per esempio per controllare la città; controllare il movimento dei cittadini, controllare i criminali, addirittura trovare le persone scomparse, che sono dei tentativi di tradurre questo in narrazione che i cittadini possono supportare.

Questa immagine l’ho presa da un articolo che è stato pubblicato sul The Guardian che annuncia che a Londra la polizia metropolitana (MET) sta introducendo tecniche di riconoscimento facciale in città dal prossimo mese e nella narrazione iperbolica che sta accompagnando questo grosso cambiamento c’è, da una parte la polizia che dice “abbiamo fatto un sondaggio: l’80% dei cittadini è favorevole a questa introduzione” perché -come dicono loro- aiuterà a scovare i criminali e a trovare le persone scomparse; in realtà c’è un unico studio indipendente, riporto sempre il Guardian, di cosa viene fatto di tutti questi dati e soprattutto qual è l’efficacia reale delle informazioni che vengono raccolte e delle conclusioni che vengono derivate da queste informazioni cioè “tu sei un criminale, tu non lo sei..” etc. L’efficacia è il 19% cioè su 100 dati che vengono raccolti, ovvero 100 matches fatti tra faccia e database, solo 19 sono corretti. Immaginate che vengono identificati 100 potenziali criminali che vengano prese delle misure contro di loro, solo 19 hanno effettivamente qualcosa da nascondere. Sono i famosi ‘falsi positivi’ che in questo caso sono assolutamente enormi.

- La polizia inizia a utilizzare le telecamere di riconoscimento facciale in diretta a Londra per scovare criminali e ritrovare persone scomparse.

- Secondo un sondaggio della London Metropolitan Police (MET) l’80% dei cittadini sarebbe favorevole.

- Ma l’unica analisi indipendente ha scoperto che la tecnologia per il riconoscimento facciale è accurata sono nel 19% dei casi

Questi però non sono i numeri della polizia di Londra. Amnesty international infatti dichiara questa tecnica della face recognition a Londra, su larga scala, è un grosso problema dal punto di vista dei Diritti alla Privacy, alla non discriminazione, alla libertà di espressione, associazione e assemblea pacifica; perché chiaramente questo viene anche usato, ed è già stato usato largamente, per quanto riguarda il controllo delle proteste. E aggiungono anche che non è il tempo di sperimentare perché non ci sono le adeguate “safeguards”, controlli democratici. Praticamente nessuno ha avuto modo di decidere: intanto “sì o no, lo vogliamo”, i cittadini non sono stati coinvolti in nessun processo democratico per stabilire se questo incontrava i loro desideri e non c’è nessun meccanismo di controllo quindi di oversight della accountability.

Quindi è una tecnologia semi-autonoma, data in mano a delle forze che anziché democratiche, come sappiamo benissimo, spesso sono depressive, né si sa bene come verrà usata. Tra l’altro il Parlamento -non che io creda troppo nel ruolo del Parlamento- non ha avuto modo di stabilire se questo è o non è in linea con i desideri del Paese. Allo stesso tempo due giorni fa è stato pubblicato un articolo scritto da una riflessione di Mark Andrejevic, in cui dice che una volta che hai postato una foto sui social network fai già parte di qualche data base, per cui non è che il meccanismo di “non ho niente da nascondere” in un contesto in cui 100 – 19 falsi positivi sia meno rassicurante, quindi tutti già contribuiamo a questo sistema, però ha dei problemi molto grossi per quello che riguarda l’esercizio del Diritto alla salute, il Diritto all’educazione eccetera eccetera.

E questo per quanto riguarda le tecnologie di riconoscimento facciale. Cioè invasive, inevitabili, perché a meno che non si cammini “così” comunque uno prima o dopo ci incappa, ad un certo punto fa anche caldo per cui o la sciarpa o la maschera non sono sicuramente la soluzione e soprattutto è una strada di non ritorno, un po’ per quel fenomeno che uno degli speakers precedenti nominava per cui dal momento in cui una città implementa e diventa subito una best practice qualcun altro si sente in dovere di seguire ma anche perché di solito l’implementazione tecnologica di una società è così radicato che non ce lo toglieremo più dai piedi. Tutto questo chiaramente va ad intrecciarsi nel contesto della smart city.

Queste sono foto di attivisti di Hong Kong che hanno cercato qualche giorno fa di tirar giù, in vera mancanza di informazioni perché non si sa effettivamente cosa contengano questi pali, ma essenzialmente si suppone ci fossero delle smart cameras, che avevano dei meccanismi di riconoscimento facciale che venivano usati esclusivamente per la repressione degli attivisti. Ci sono molti studi adesso negli Stati Uniti per quanto riguarda il fatto che questa tecnologia discrimina e va scapito soprattutto per quanto riguarda quelli che sono le minoranze etniche, i migranti, i più marginali.

Secondo esempio, questa è una slide terrificante ma vi dà un’idea di quale sia la complessità del problema: Chi ha mai sentito parlare di Adtech? È terrificante, non sono esperta di Adtech, capisco di più altre tecnologie comunque è un termine un po’ generico, che si riferisce ad un fenomeno molto complesso che è l’advertisement technology quindi tutto quello che è l’ecosistema che di fatto fa arrivare sui nostri telefoni una pubblicità molto invasiva relativa a quelli che sono i nostri interessi o che magari se sono qua a Milano mi suggerisce dove andare a mangiare stasera. Allora è una tecnologia per molti versi conveniente per molti di quelli che attivano molto spesso la geolocalizzazione nel cellulare perché di fatto piace avere informazioni servite su misura ma anche il sistema che si nasconde dietro a questa cosa è molto complesso.

Questa è una rappresentazione molto semplificata di come si passa dall’impresa che vuole arrivare all’utente a quella che per esempio è un giornale; c’è di fatto, semplificando, un mercato in tempo reale che collega i dati che noi mettiamo su questo cellulare, la fonte primaria di questi dati, e il valore dei nostri dati per quanto riguarda chi paga per fornirci queste pubblicità. Questo il senso per quanto riguarda il capitalismo diciamo moderno, quindi io pago per fornirti delle informazioni, prima cartelloni, televisioni, adesso anche sul cellulare. Di fatto però sempre di più per quanto riguarda le campagne elettorali: è lo stesso sistema di aste in tempo reale, ci arriva un contenuto più o meno politico. Per esempio Facebook ha il suo proprio mercato, della nostra attenzione e anche un database dove, ad esempio, classifica delle informazioni come politiche e delle altre come non. Annesso a questo per esempio tutta una serie di altri problemi, tutto come, non so, il contenuto di OffTopic, ha a che fare comunque con la profilazione degli utenti; ci sono delle regole, la famosa GPR (general protection regulation), questo librino enorme, che cerca di regolamentare i nostri dati personali e chiede allo stesso utente il famoso consenso informato che le persone usualmente non leggono per altri problemi.

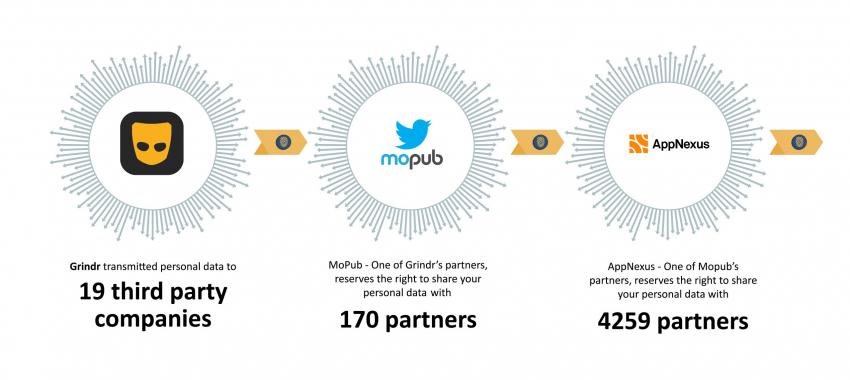

Ma anche in contesto di GPR, quindi per cui dal 2018 siamo in teoria protetti, o ancora in una fase di transizione, è stato pubblicato a gennaio questo studio molto interessante che guarda ad una serie di dating apps, Tinder, OkCupid, apps di uso corrente ma che sicuramente nella nostra testa non colleghiamo, all’uso dei dati personali. Allora queste apps sempre a causa della regolamentazione europea ti chiedono se vuoi dare il consenso all’utilizzo dei dati personali e ti chiede di darlo SOLO a 19 imprese di parti terze, diciamo come loro monetizzano la nostra presenza su queste apps. Poi quando si va a vedere, queste 19 imprese danno il consenso ad altri 170 partners che poi vai a vedere se ci si distanzia un po’ diventano 4259. Questo studio è stato fatto da un’associazione di consumatori a livello europeo (ass. ombrello di consumatori a livello europeo) ovvero casi depositati da consumatori internazionali tra cui in Norvegia raccontano twitter etc e le imprese collegate di cui di fatto sicuramente non avrete sentito parlare che monetizzano i nostri dati, ad esempio AdColony, OpenExe…che appunto può sembrare solo una cosa legata al capitalismo il far arrivare il contenuto all’utente ma anche avere conseguenze concrete per esempio nella sfera intima (se e quando vogliamo incontrare qualcuno e non solo) ma anche a livello politico per quanto riguarda le campagne politiche etc.

L’ultimo esempio triste prima di passare alle cose carine è qualcosa di cui non si è discusso ma è l’impatto ambientale delle industrie e dei dati. Non se ne parla MAI, si parla sempre di narrazione ma delle economie enormi che ci sono dietro, mai dei costi data centers di Uber, che si muovono in un sistema che richiede un dispendio enorme di energia, quindi di fatto praticamente le previsioni sono che consumeranno entro il 2025 1/5 dell’impatto ambientale globale. Di fatto più alto degli aerei e delle navi ma non ne parla nessuno.

- Esempi d’impatto ambientale dell’industria della tecnologia/dei dati :

- 1MB = 7,072gr CO2

- 3/4G 1MB = 35,46 gr CO2

- 5G = ?

- 1 smartphone = 62 minerali;

- 372 passaggi in manifattura

Per esempio un megabyte di dati consuma quel tot di energia di Co2 ed è da capire per esempio il 5G cosa farà…una scala completamente diversa da quella che usiamo oggi. Si parla di sfruttamento delle risorse: un cellulare ha a che fare con 62 minerali con tutte le dinamiche estrattive e colonialiste con cui abbiamo a che fare; questa narrativa non la troverete da nessuna parte, lo stesso White Paper dell’UE fa un po’ revisione..è grosso così ma non menziona neanche l’impatto ambientale dell’artificial intelligence.

Che linee di fuga attive e collettive possiamo trovare?

La prima è il discorso del decor design che è un esperimento simile a quello di stamattina quindi la creazione di narrative e contro narrative che riescano in qualche modo a cambiare il linguaggio ma in qualche modo a porre il problema più semplicemente come il discorso ecologico collegato alle nuove tecnologie.

Un esempio molto italiano si chiama Dowse, ed e’ la creazione di un gruppo di hacker: una scatolina che ha come obiettivo quello di permetterci di vedere cosa succederà in una smart home dove ci sono una serie di dati in entrata e dati in uscita. Ti permette di vedere cosa accade nella tua home network ma anche di bloccare eventuali scambi di dati non desiderati. La ragione per cui è qua nonostante sia software + hardware ha un’intuizione molto carina cioè quella di cambiare il modo in cui parliamo di sicurezza, quella informatica che adotta un linguaggio molto militarista, il cui risultato è che la gente sicuramente non inizia ad interessarsene. I più pensano che “sono cose così complesse che lascia stare”. Ed e per questo che Dowse cerca di fare un intervento linguistico e creare un immaginario diverso, ti dice “guarda puoi controllarlo in modo molto più semplice di quello che credi”.

La seconda soluzione è quella di investire nell’educazione ma non intendo semplicemente quella nelle scuole, anche perché ho imparato prima da sola che non lì. Però dobbiamo capire come funzionano queste tech che hanno comunque un’aura di magico che ci invita intanto a delegare tutte le funzioni e decisioni e non contribuisce a renderci sicuramente utenti esperti. Bisogna trasformare questa literacy in un percorso di apprendimento collettivo come viene fuori dal lavoro di un hacker milanese, Claudio Agosti [Vecna], che è l’anima di nostro progetto “Algorithms Exposed” (ALEX) e che ha dietro un un progetto che esisteva già, Tracking Exposed: che ti permette di scaricare degli addons sul tuo browser, che ti fanno vedere la tua “dieta informativa”: per dirla in breve cioè cosa ti viene servito in contenuti da Facebook, Amazon, Pornhub. Anche qui, dietro c’è lo sforzo di creare un immaginario molto diverso, che mette l’utente al centro.

“Technology is not neutral. We’re inside of what we make, and it’s inside of us. We’re living in a world of connections — and it matters which ones get made and unmade.”

— Donna Haraway. “A Cyborg Manifesto”, 1991.

Per concludere e questo è un messaggio un po’ generale bisogna buttarla sulla politica. È vero che più parlo con gente sia in Italia che fuori, l’idea è che la politica sia una cosa molto sporca, poi è vero che se ne parla in tante sfaccettature, con la P grande, piccola, quella vicina ai partiti politici etc… lo stesso Fb che ha questi database per flaggare, segnalare il contenuto politico lo fa come per dire che è brutto sporco e cattivo quindi cercare di recuperare questa politica come un’azione collettiva, quindi quello che stiamo cercando di fare qua noi oggi ma anche di pensare alla politica della tecnologia stessa che non sono elementi neutrali ma cose più complesse -e concludo con una slide sul cyborg manifesto di Donna Haraway in cui inserì un pensiero femminista in quella che è la tecnologia ma lo uso solo per collegare il corpo alla tecnologia, visto che io mi occupo tanto di sicurezza digitale ma vivo tanto nel mondo fisico dato che sono anche una grande appassionata di sport come società ci preoccupiamo molto di quello che mangiamo (mangiare bene etc…) ma ci preoccupiamo molto meno di quello che mettiamo nella testa idee di reclaim, di well being (benessere) ha a che fare sia col digitale che con la tecnologia, due questioni che mettono insieme l’autodifesa digitale e personale, ancorare quella che è una cosa un po’ astrusa come una a un ambito che spesso è per altro collettivo come la pratica sportiva. E con questo pensiero un po’ confuso finale a cui sto pensando di lavorare di recente.